Découvrez nos

ressources

Matériel nécessaire :

- 1 robot

- 1 ordinateur

- 1 ballon de baudruche (de préférence vert)

- Recommandé : portique et ficelle pour accrocher le ballon en hauteur, arène

Les + de cette activité :

- Ludique

- Appréciée de tous les âges

- Parfaite pour introduire le principe de l’apprentissage par renforcement

Durée :

40 à 60 minutes

Age :

+ 8 ans

Configuration logiciel :

Mode "suivi de ballon (vert)"

L’objectif est d’utiliser l’apprentissage par renforcement afin d’entraîner le robot à suivre un ballon. En se basant sur le principe d’essais et d’erreurs, le robot ajuste progressivement son comportement en réponse aux retours de son environnement, représentés par des récompenses.

Introduction

Construisez votre arène avec un ballon vert suspendu au centre, servant de repère visuel pour le robot. Celui-ci doit apprendre à le suivre en explorant l’espace. Assurez un bon contraste sol/parois, un éclairage homogène et un sol propre pour garantir une détection fiable, une mobilité fluide et des conditions d’observation optimales.

Paramétrage

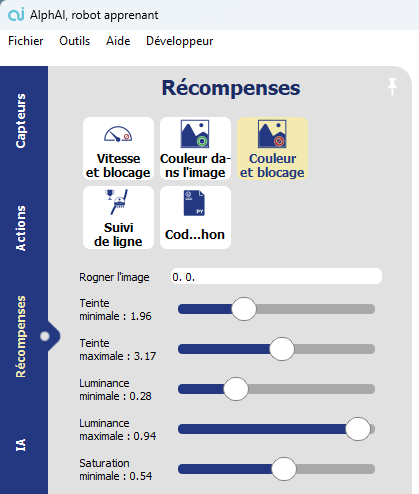

Connectez le robot à l’ordinateur puis choisissez la configuration d'exemple “suivi de ballon (vert)”.

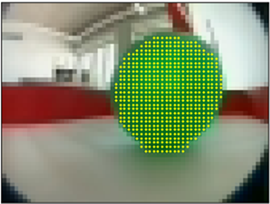

Il est important de vérifier que, lorsque le robot regarde le ballon, les pixels verts du ballon soient correctement identifiés. Cela se traduit par l’apparition de petites marques jaunes sur l’image captée par la caméra. Aucun autre pixel vert ne doit être visible ailleurs dans l’image.

Si ce n’est pas le cas, vous devrez ajuster les paramètres de détection de couleur dans l’onglet « Récompenses » afin d’obtenir un résultat satisfaisant.

Assurez-vous également que le ballon reste correctement détecté, même lorsqu’il est observé sous différents angles.

Entraînement

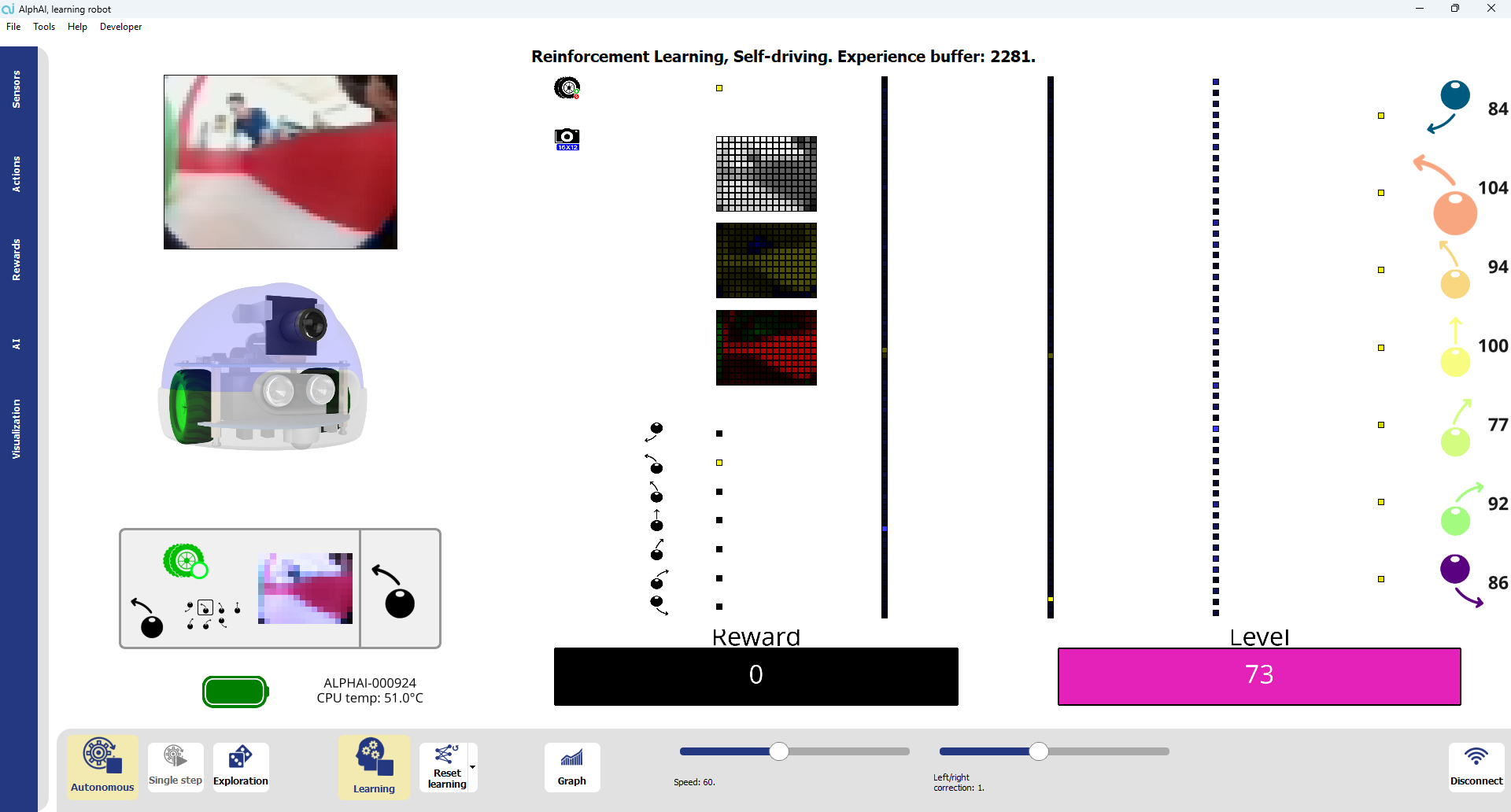

Activez le bouton "Autonome" pour lancer la phase d’apprentissage.

Le robot entre alors en phase d’exploration, durant laquelle il adopte une stratégie basée sur l’essai-erreur. Il exécute différentes actions de manière aléatoire afin d’explorer les possibilités qui s’offrent à lui. Cette étape est cruciale pour qu’il découvre, par lui-même, les conséquences de ses choix.

À chaque action réalisée, le robot reçoit un retour sous forme de récompense positive, négative ou nulle. Ce mécanisme l’incite à privilégier les comportements bénéfiques et à éviter ceux qui sont inefficaces ou contre-productifs. Progressivement, il affine sa stratégie et améliore ses performances.

Vous pourrez constater une évolution notable dans ses actions : les mouvements aléatoires et non pertinents se raréfient, tandis que les comportements efficaces se renforcent. Le robot tend ainsi à se concentrer de plus en plus sur son objectif final prédéterminé.

Test de l’apprentissage

Lorsque le comportement du robot devient cohérent (c’est-à-dire qu’il suit le ballon de manière efficace et régulière) : Désactivez le bouton "Exploration".

À ce stade, le robot applique uniquement les actions qu’il a apprises comme étant les plus efficaces, sans introduire d’exploration aléatoire. Cela garantit un fonctionnement plus stable, plus prévisible et optimisé, reposant sur l’expérience acquise durant la phase d’exploration.

Conclusion

Nous avons utilisé ici un algorithme d’apprentissage par renforcement. À travers une phase d’essais et d’erreurs guidée par un système de récompenses, le robot apprend progressivement à adopter un comportement optimal de suivi visuel.

À chaque étape, l’agent effectue une action qui modifie l’état de l’environnement. L’agent doit alors décider s’il explore davantage l’environnement pour découvrir de nouvelles récompenses, ou s’il exploite ses connaissances actuelles pour choisir les actions les plus rentables dans un état donné. Ce comportement reflète le compromis fondamental en apprentissage par renforcement entre exploration et exploitation.

Une stratégie d’apprentissage réussie implique donc une réduction progressive des essais inutiles, ainsi qu’un comportement autonome de plus en plus adapté et cohérent au fil du temps.

%402x.svg)