Entdecken Sie unsere Lehrmaterialien

Benötigtes Material :

- 1 Roboter mindestens

- 1 Computer/Roboter

- Minimale individuelle Arena

Software-Konfiguration :

- Beispielkonfiguration: "Lernen durch Verstärkung - Vermeidung von Hindernissen".

Dauer :

30 Minuten

Alter :

8 Jahre und älter

Die + dieser Aktivität :

- Verstärktes Lernen einführen

- Verstehen des Prinzips "Try and learn" = pädagogischer Nutzen

- Kann mit dem Simulator durchgeführt werden

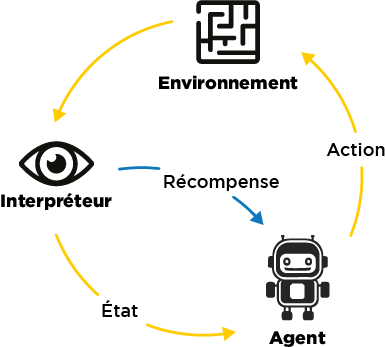

Bei dieser Aktivität wird ein Roboter beobachtet, der nach dem Prinzip des verstärkten Lernens selbstständig lernt. Daraus lassen sich recht allgemeine Schlussfolgerungen über die notwendigen Voraussetzungen für effektives Lernen ziehen.

[Videoinhalt folgt]

Einführung

In dieser Aktivität wird der Roboter nicht trainiert: Es ist der Roboter selbst, der die Beispiele erstellt, auf die er sich stützen kann, um die richtigen Entscheidungen für die auszuführenden Handlungen zu treffen.

Damit der Roboter zwischen richtigen und falschen Entscheidungen unterscheiden kann, enthält der Algorithmus ein Belohnungssystem.

Hier erhält der Roboter je nach ausgeführten Aktionen die folgenden Belohnungen:

- vorrücken: 100 Punkte

- drehen: 82 Punkte

- zurückgehen: -50 Punkte

- Der Roboter erhält auch eine Strafe von -50 Punkten, wenn er sich selbst blockiert

In der Leiste "Level" sehen Sie die durchschnittliche Punktzahl der Belohnungen, die der Roboter erhält. Sein Ziel ist es, diese Punktzahl zu maximieren; daher wird er nach und nach lernen, die Aktionen auszuwählen, die ihm die optimalen Belohnungen einbringen, indem er berücksichtigt, was seine Sensoren ihm anzeigen

Wir werden also den Fortschritt des Roboters während seines Lernprozesses beobachten können. Bauen Sie zunächst eine Arena ohne Hindernisse auf und setzen Sie den Roboter hinein.

Selbstständiges Lernen des Roboters

Wählen Sie in der AlphAI-Software die Beispielkonfiguration: "Lernen durch Verstärkung - Vermeidung von Hindernissen".

In dieser Aktivität ist es der Roboter, der selbstständig lernt!

Starten Sie den autonomen Modus und beobachten Sie Ihren Roboter. Wie verhält er sich?

Wenn der Roboter eine Aktion identifiziert hat, für die er eine Belohnung erhält (z. B. Drehen), kann es sein, dass er von nun an nur noch diese Aktion ausführen will.

Wir aktivieren nun die Schaltfläche "Erkunden": Von Zeit zu Zeit wird sich der Roboter dann entscheiden, eine zufällige Aktion auszuführen. So kann er herausfinden, dass die Aktion, die er gewählt hätte, vielleicht nicht diejenige ist, die der optimal möglichen Belohnung entspricht, und so sein Lernen mit neuen Daten bereichern.

Normalerweise lernt er nacheinander, geradeaus zu gehen, sich umzudrehen, wenn er gegen ein Hindernis stößt, und dann, diese Hindernisse im Voraus zu erkennen und somit zu drehen, bevor er dagegen stößt! Dieser Lernprozess dauert etwa zehn Minuten.

Zögern Sie nicht, den Modus "Erkunden" zu deaktivieren, wenn der Roboter beginnt, mehrheitlich die richtigen Aktionen auszuwählen.

Bilanz und Feedback

Wenn das Lernen abgeschlossen ist, halten Sie Ihren Roboter an und klicken Sie in der unteren Leiste auf "Graphen" (wenn die Schaltfläche nicht erscheint, ändern Sie die Anzeige der Einstellungen auf "Erweitert" oder "Experte"). Sie können dann im unteren Diagramm die Entwicklung der vom Roboter gemachten Fehler beobachten: Normalerweise sollten die Werte zu Beginn der Aktivität sehr hoch sein und dann nach und nach gegen Null tendieren: Der Roboter hat sich selbst beigebracht, keine Fehler mehr zu machen!

Die Funktionsweise des Lernens durch Verstärkung lässt sich folgendermaßen zusammenfassen:

Was der Roboter zum Lernen braucht :

- Wiederholung einer Aufgabe: Der Roboter findet nicht sofort die richtige Lösung, erst durch Wiederholungen wird er besser.

- Erkundung: Manchmal muss der Roboter neue Ideen ausprobieren, um nicht in einer nicht optimalen Lösung stecken zu bleiben.

- Belohnungen oder Strafen : Der Roboter braucht Hilfe von außen, um zu beurteilen, ob seine Entscheidungen optimal sind oder nicht.

- Der Stellenwert vonFehlern: Der Roboter lernt aus seinen Fehlern, ohne sich entmutigen zu lassen! Durch Fehler lernt er, welche Handlungen er nicht wiederholen darf!

%402x.svg)